Chatless

综合介绍

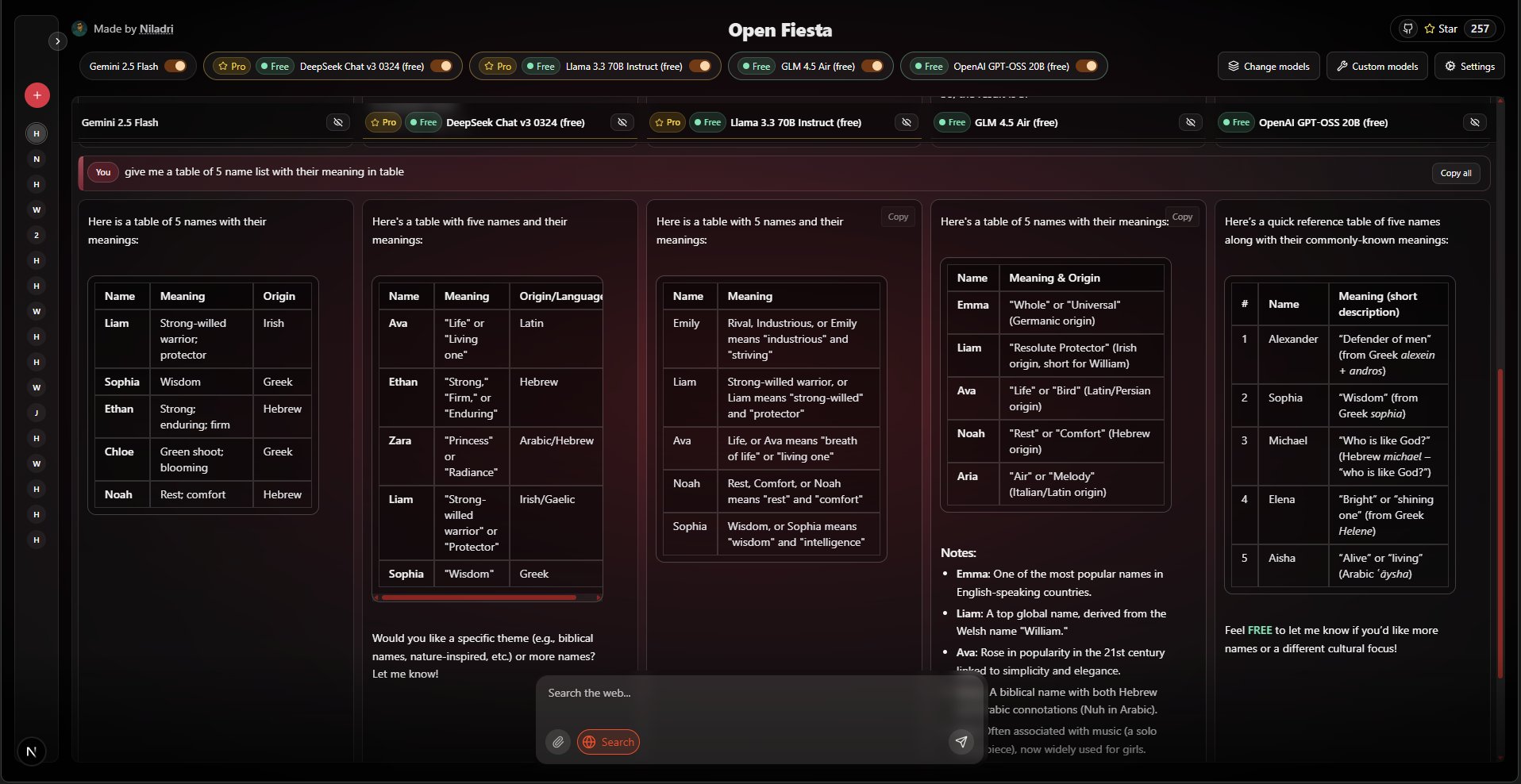

Chatless是一款追求极致简洁、轻量化与高性能的跨平台AI聊天客户端,支持在Windows、macOS和Linux上运行。这款工具的诞生,源于开发者本人一个非常具体的需求:在性能不佳的办公电脑上,流畅地使用部署在家中高性能主机上的Ollama等AI服务。为解决市面上多数客户端资源占用过高导致卡顿的问题,同时避免复杂配置,开发者使用Tauri 2.0和Next.js 15技术栈,从头构建了Chatless。它不仅打包体积小巧(macOS版仅20MB),性能表现也十分出色。软件的设计哲学是“简约轻松”,旨在减少用户的心智负担,提供直观有效的交互。其名称“Chatless”寄托了开发者的期望:希望我们能少花些时间追赶AI,多关注能提升个人幸福感的事情。

功能列表

- 轻量级与高性能:基于Rust核心的Tauri 2.0和Next.js 15开发,确保了软件极低的资源占用和流畅的运行表现,解决了在低性能电脑上使用AI的卡顿问题。

- 本地化优先:优先并深度支持连接Ollama。无论是AI聊天服务,还是知识库内容处理(嵌入生成),都可以配置为使用本地或远程的Ollama实例来完成,确保数据私密性。

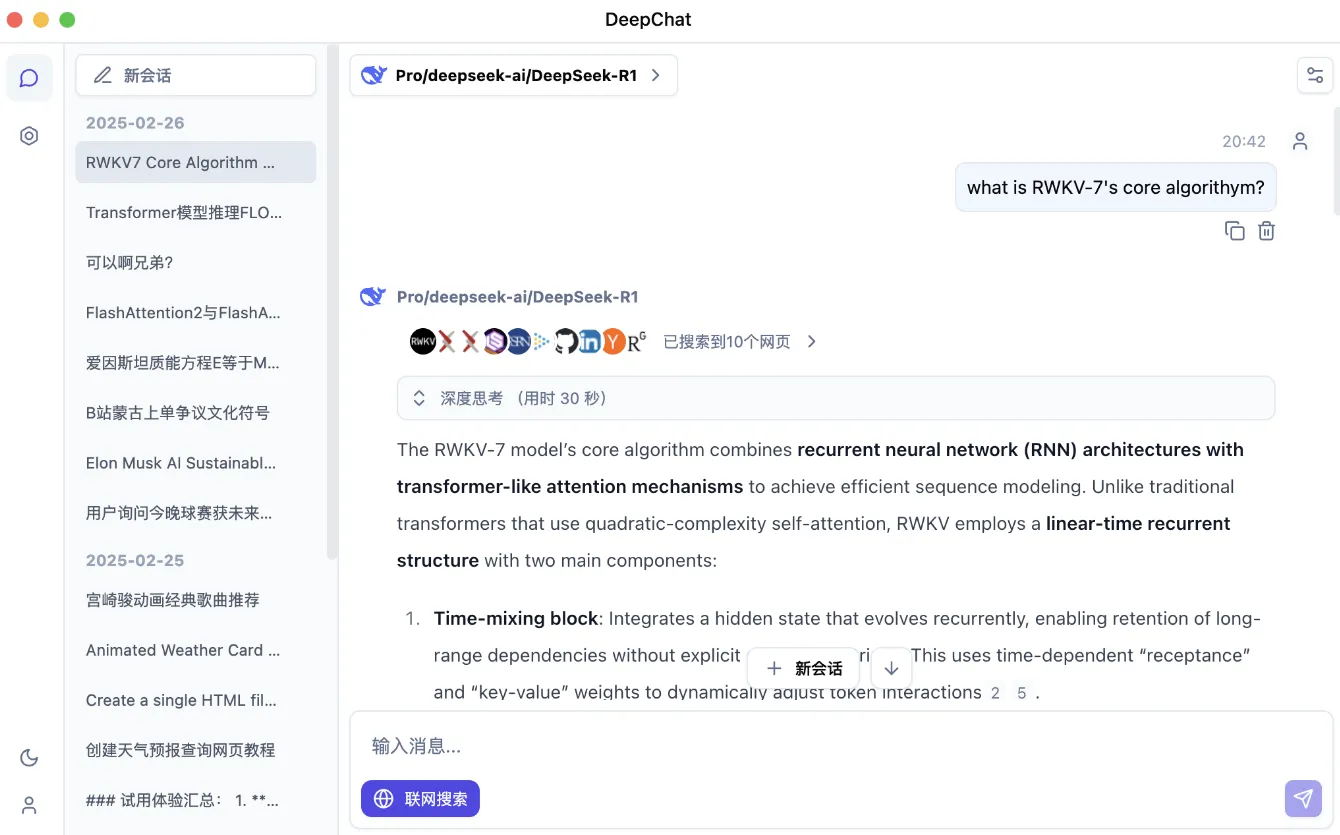

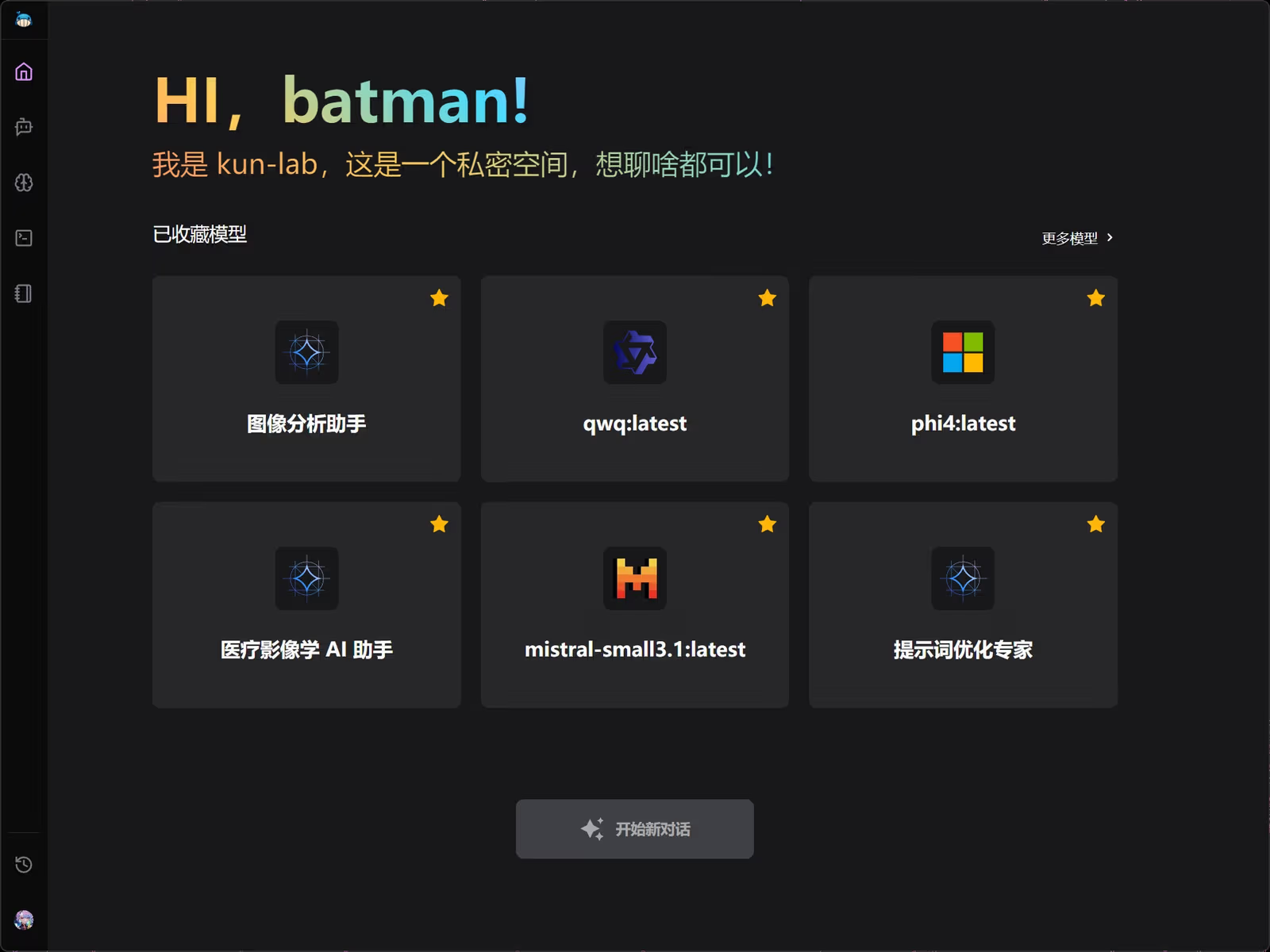

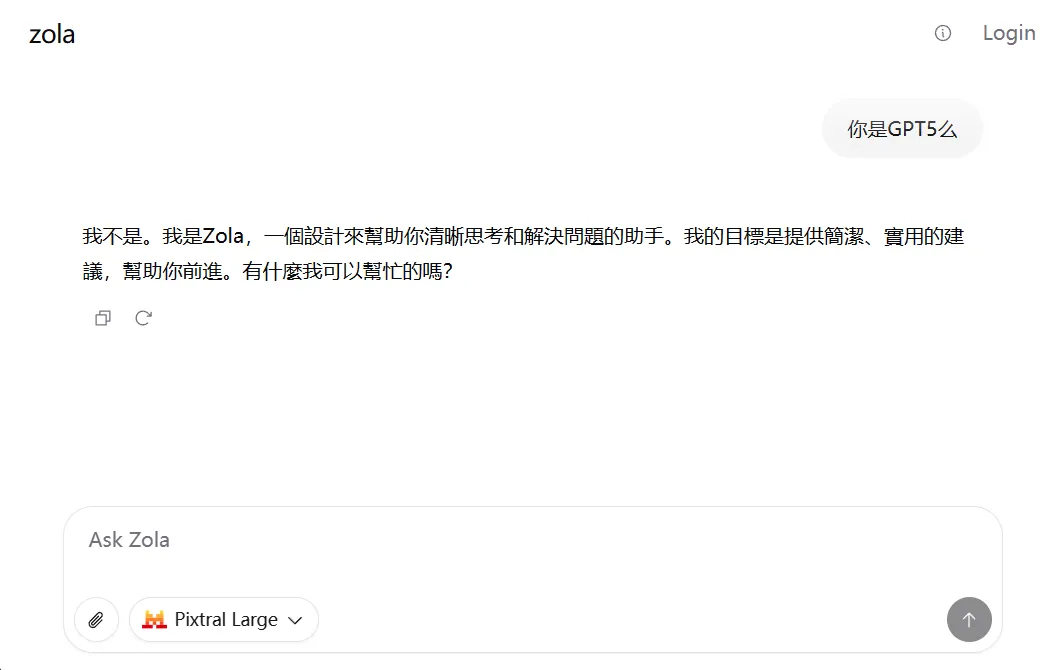

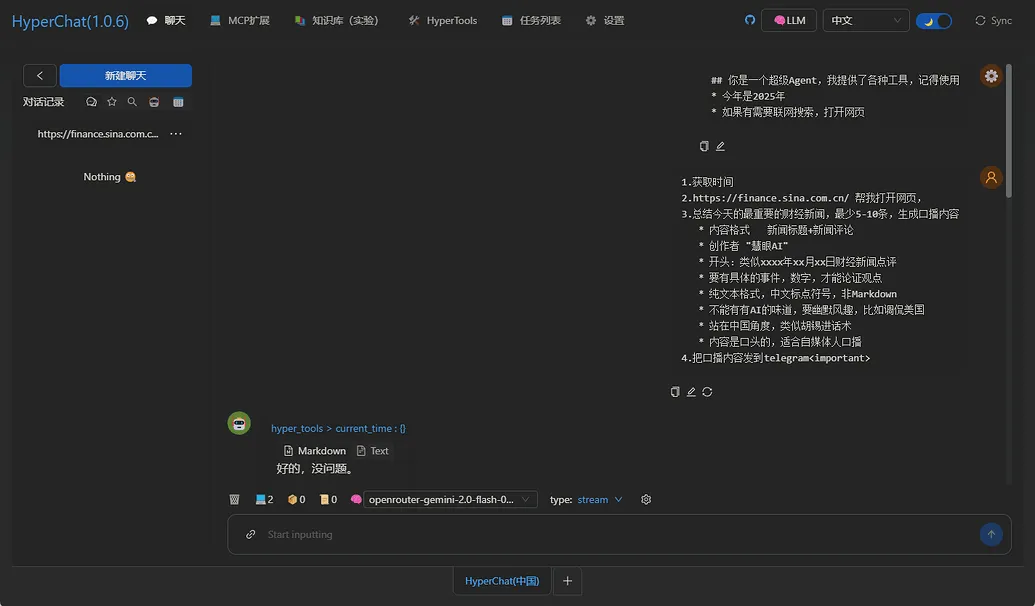

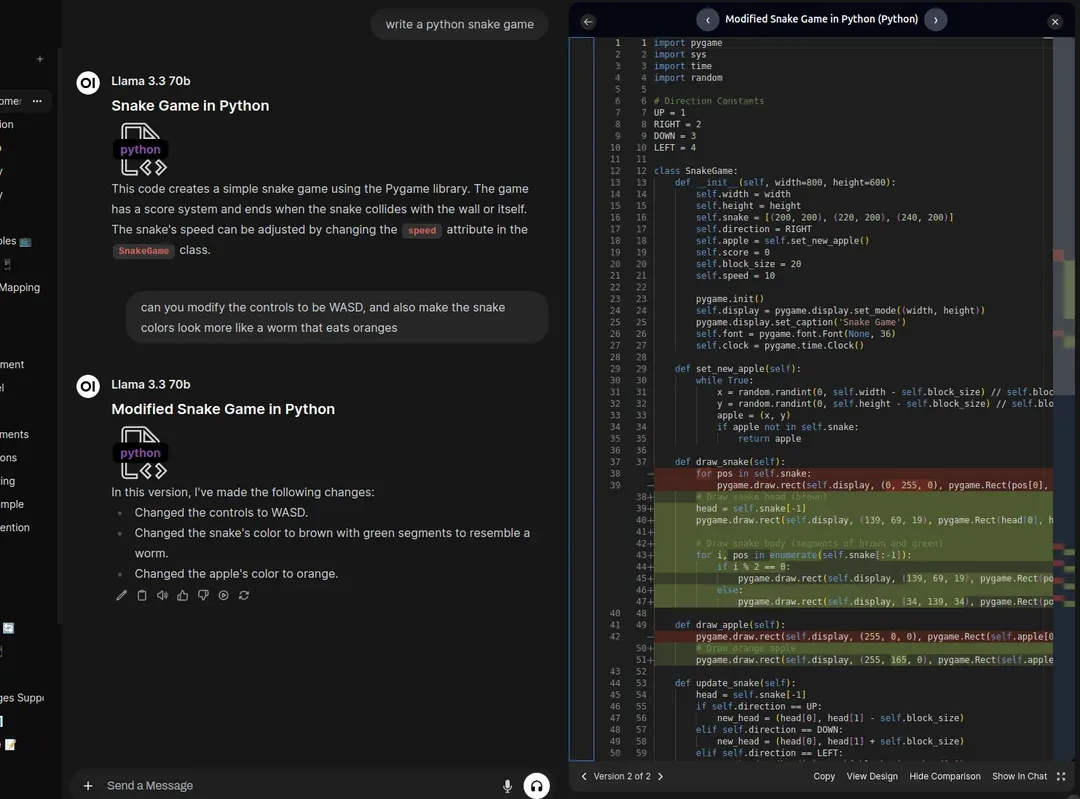

- AI聊天:提供简洁直观的聊天界面,支持与AI进行多轮对话,并能方便地管理和查阅历史记录。

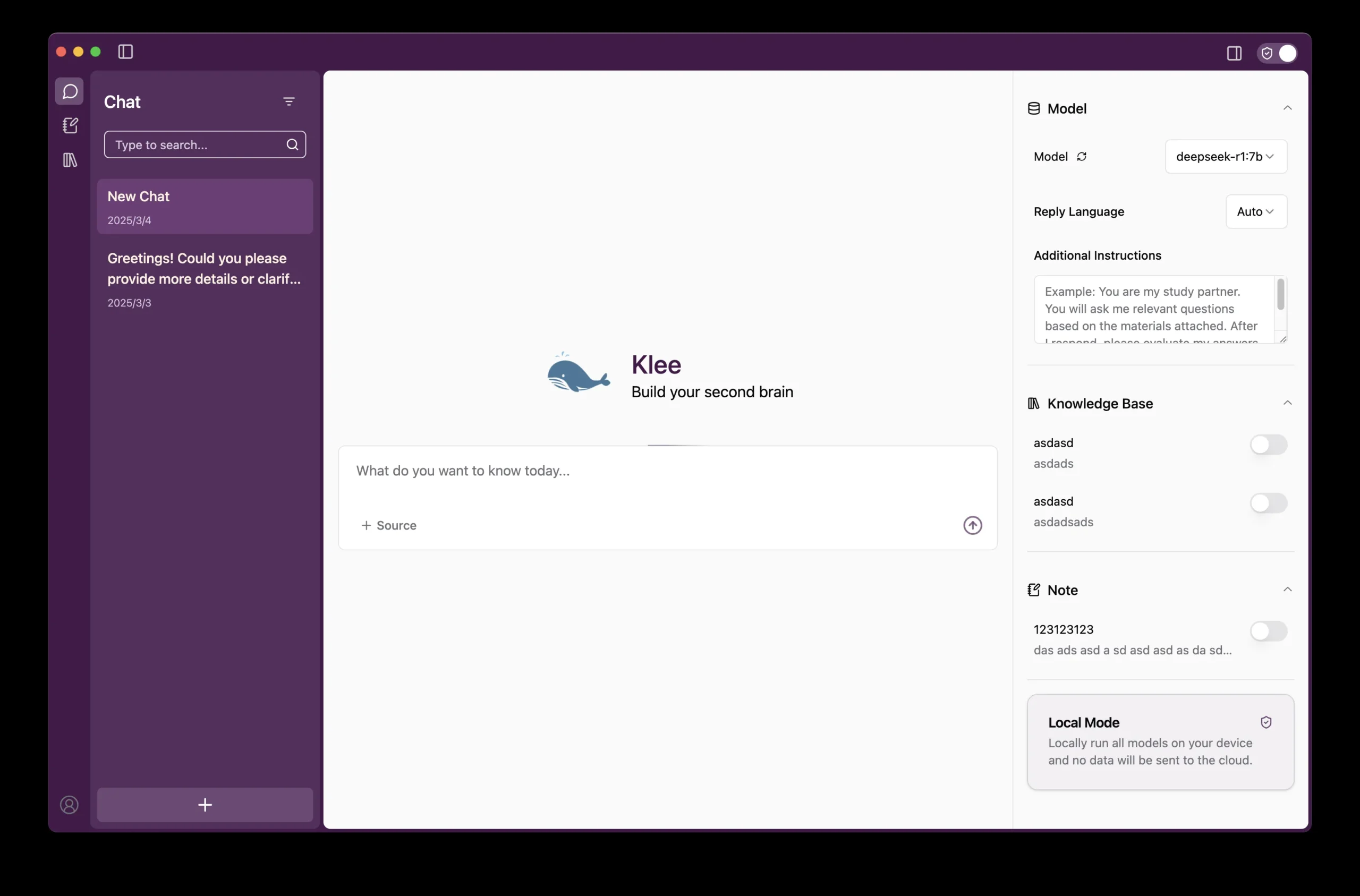

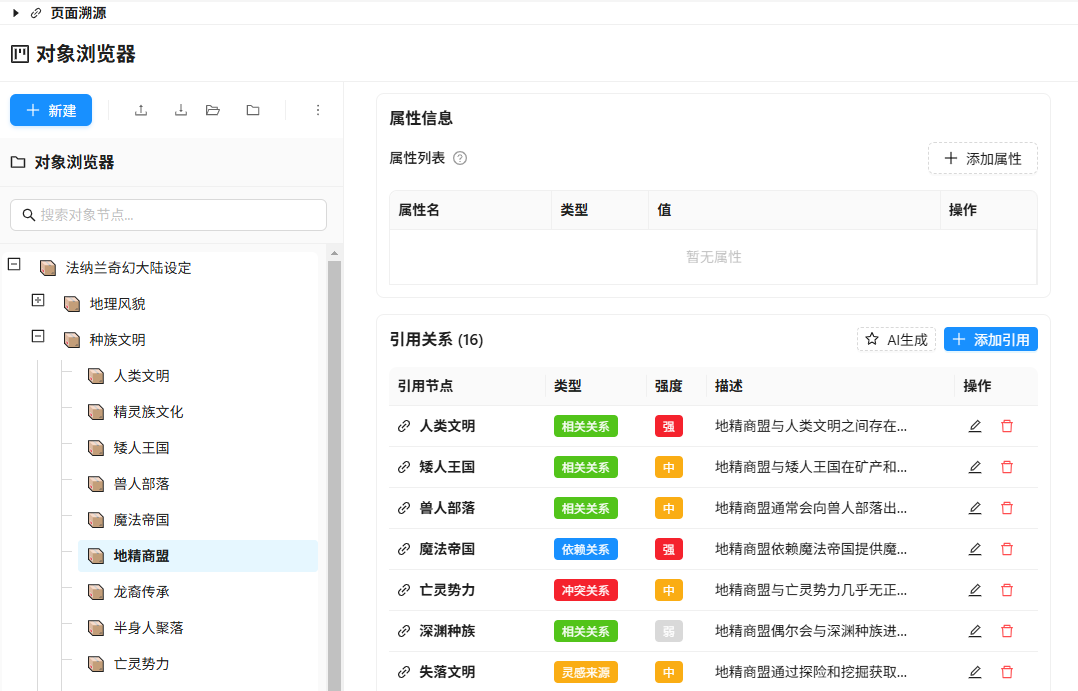

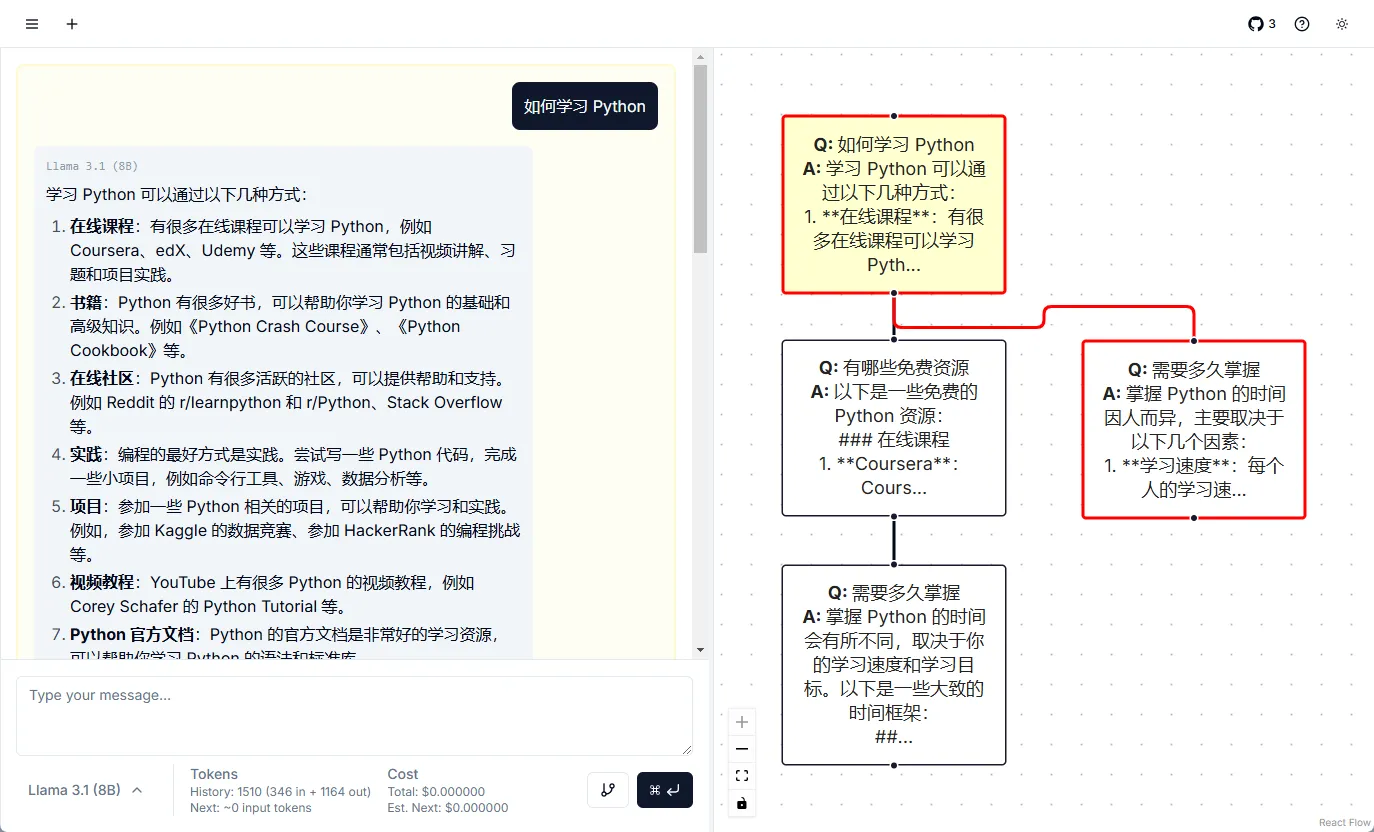

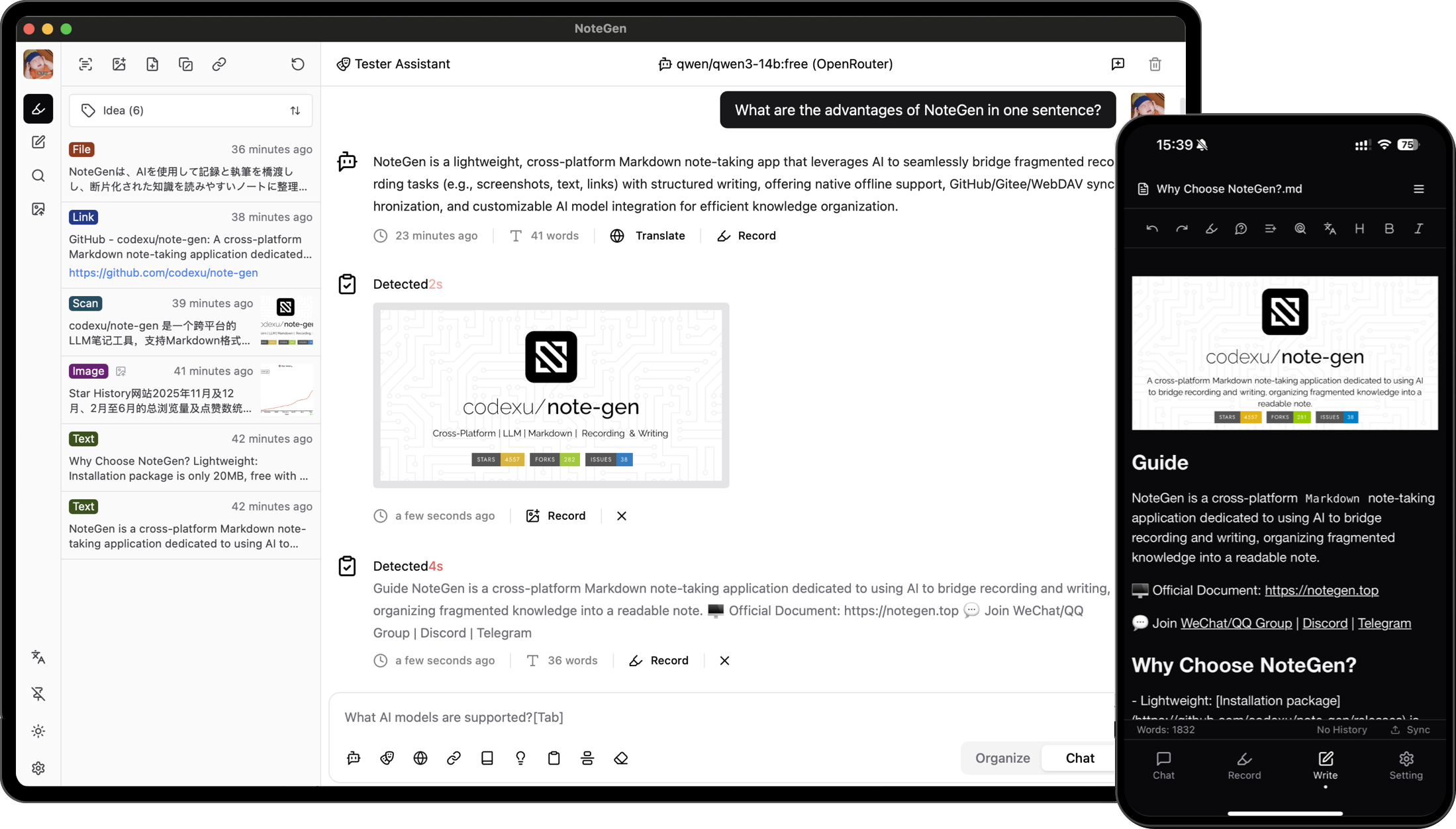

- 本地知识库:内置了基于RAG(检索增强生成)模式的知识库功能。用户可以导入本地文档,创建个人专属知识库,让AI基于指定内容进行总结、分析和问答。该功能为自主实现,没有引入LlamaIndex等重型框架,以保持软件的轻量化。

- 本地文档解析:支持直接拖入或选择单个文档,快速与文档内容进行对话,无需预先创建完整的知识库,方便进行一次性的快速分析。

- 小巧易于分发:macOS版本打包后仅20多MB,非常小巧,便于下载和分享。

- 适度的个性化:在设置中提供了一些关于使用习惯的调整选项,让用户可以在保持简洁的同时,根据自己的偏好进行微调。

使用帮助

Chatless的设计初衷就是为了简化AI聊天体验,尤其适合那些希望在日常使用的低配电脑上,调用另一台高性能设备上AI能力的用户。

安装与配置

由于项目尚在开发完善中,正式版发布后,最直接的安装方式将是从GitHub项目的Releases页面下载对应您操作系统(Windows/macOS/Linux)的安装包。

首次使用配置流程:

- 启动应用:打开Chatless后,首先需要设置AI服务的连接点。

- 配置AI模型提供商:

- 点击进入设置界面,找到“AI模型提供商”(AI Provider)选项卡。

- Chatless优先支持Ollama。您需要在这里填入Ollama服务的API地址。

- 如果Ollama部署在您的本机,地址通常是

http://localhost:11434。 - 如果您像开发者一样,将Ollama部署在家里的另一台主机或远程服务器上,并做了公网映射,那么就填入那个公网地址,例如

http://your.domain.com:11434。

- 如果Ollama部署在您的本机,地址通常是

- 配置完成后,客户端即可连接到AI模型进行对话。

核心功能操作指南

- 进行AI聊天

- 在主界面的输入框内输入您的问题或想说的话,按回车键即可发送。

- 对话窗口会像常见的聊天软件一样,清晰地展示您和AI的交流过程。

- 使用本地知识库进行对话

- 第一步:创建知识库。进入“知识库”(Knowledge Base)管理界面,点击创建,并为它命名。

- 第二步:添加文档。进入新建的知识库详情页,将您的本地文档(如PDF、TXT等)拖拽进来或点击上传。Chatless会自动处理这些文档。

- 第三步:配置知识库嵌入方式。在知识库设置中,您可以选择使用本机的计算资源还是远程的Ollama服务来生成文本嵌入(Embedding)。

- 第四步:在聊天中使用。回到主聊天界面,在输入框上方或侧边栏,会有选择知识库的选项。勾选您想使用的知识库后,再向AI提问。此时,AI的回答将会基于您提供的知识库内容,从而实现对特定领域文档的精准问答和分析。

- 直接与本地文档对话

- 如果您只是想快速问一个文档里的问题,而不想创建永久的知识库,可以使用“本地解析文档对话”功能。

- 在相应的功能入口(通常在主界面或侧边栏),直接选择或拖入一个本地文件。

- 上传解析后,会进入一个临时的聊天会话。在这个会话中,AI的回答将完全围绕该文档的内容展开。

- 管理历史记录

- 所有的聊天记录都会被自动保存在本地。您可以随时在“历史记录”页面回顾、搜索或删除之前的对话。

应用场景

- 新旧电脑的算力协同在办公室使用性能一般的笔记本电脑,通过Chatless连接到家里24小时开机的高性能主机上部署的Ollama服务。这样既能利用强大的AI算力辅助完成编写代码、润色文案等工作,又不会让办公电脑变得卡顿,实现了资源的最优分配。

- 个人专属知识库构建学生或研究者可以将课程资料、学术论文、项目笔记等导入Chatless创建个人知识库。在撰写论文或复习时,可以直接向AI提问:“根据我的资料,请总结一下‘Tauri 2.0’的核心优势”,AI能立刻基于私有数据给出高度相关的答案,成为一个懂你的专属学习和研究助理。

- 安全离线的企业文档分析企业内部有许多包含敏感信息的报告或技术文档。通过在内网服务器部署Ollama,并使用Chatless作为客户端,员工可以在一个完全与公网隔离的环境下,对这些文档进行智能查询和分析,确保了商业机密和数据的绝对安全。

QA

- Chatless和其他AI客户端最大的不同是什么?最大的不同点在于其明确的定位和技术选型。它专为解决“低配电脑使用AI卡顿”这一痛点而生,因此选择了以轻量和高性能著称的Tauri + Next.js技术栈,并有意避开了LlamaIndex这类可能增加软件体积和复杂度的重型框架。它的核心是简约、实用和性能。

- 这款软件的技术栈是什么?它采用了

Tauri 2.0作为跨平台应用框架,Next.js 15作为前端界面库。Tauri基于Rust语言,能打包成体积非常小且性能优异的本地应用;Next.js是优秀的React框架,同样以性能著称。 - 为什么软件要命名为“Chatless”?根据开发者的阐述,这个名字寄托了一种期望。他希望用户能够“少花一些时间在ai聊天和对ai的追赶上,多把时间花在能真正能提升个人幸福感的事情上”。它提醒用户,AI只是一个工具,核心还是我们的生活本身。

- 这个项目的当前状态和未来计划是怎样的?目前项目完成了约85%的核心功能,已经达到基本可用的状态。开发者正在进行功能测试和细节优化,计划很快会在GitHub上开源代码。下一步的开发计划是实现“mcp”相关功能(具体功能待开发者公布)。